Rechtliche Fallstricke der Digitalisierung in den Werkstoffwissenschaften

Wem gehören eigentlich die ganzen Daten die wir erheben? Wollen wir personenbezogenen Daten haben, oder nicht? Auch für die Werkstoffwissenschaften bringt die Digitalisierung eine ganze Reihe von neuen rechtlichen Fragestellungen mit sich. Wir haben dazu mit dem Rechtsanwalt Daniel van Geerenstein gesprochen, der sich beim Verband Deutscher Maschinen- und Anlagenbau (VDMA) mit solchen Fragen beruflich beschäftigt.

Herr van Geerenstein, der VDMA ist mit 3.300 Mitgliedern Europas größter Industrieverband. Wie sehen Sie als stellvertretenden Leiter der Abteilung Recht den derzeitigen Stand der Digitalisierung ihrer Mitglieder?

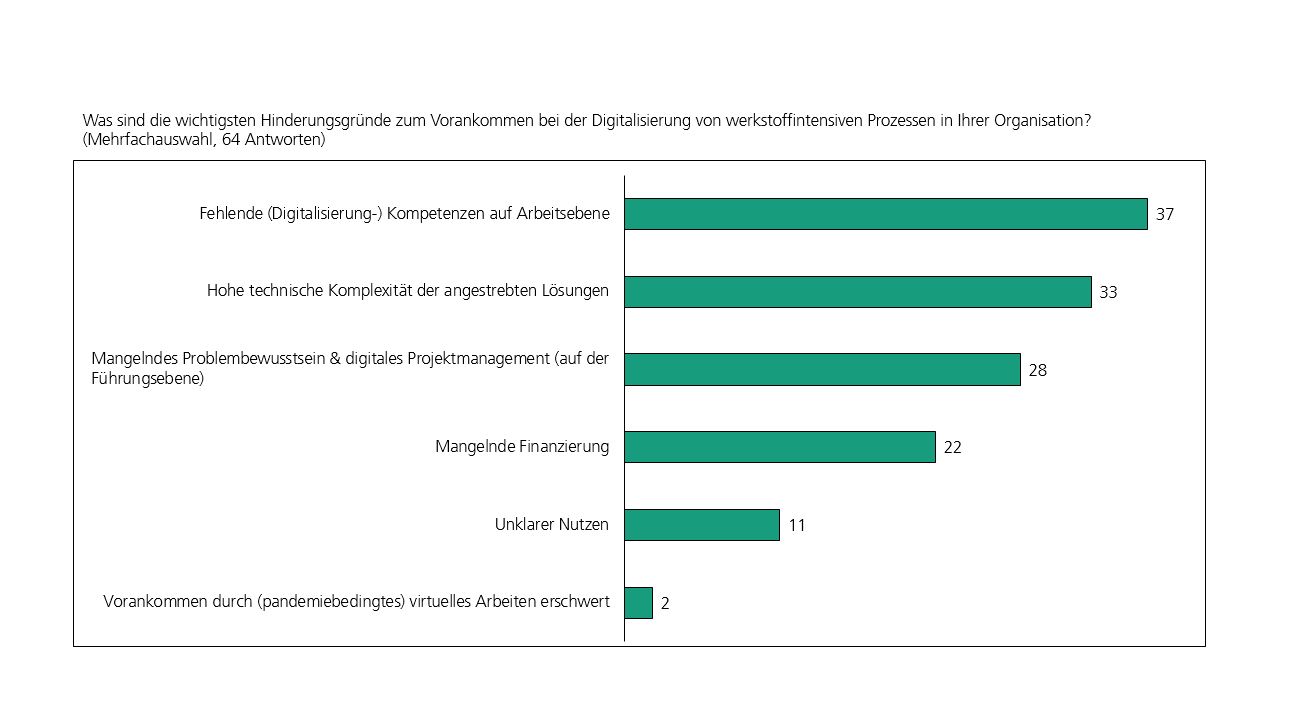

Der VDMA vertritt hauptsächlich kleinere und mittelständische Unternehmen. KMU machen ca. 80% unserer Mitglieder aus. Ich würde sagen, die sind insgesamt auf keinem schlechten Weg, aber der große Schub steht uns noch bevor. Mit Auslastungen von bisweilen 120-130% in den letzten Jahren ging es uns sehr lange Zeit sehr gut. Jetzt, wo sich die Wirtschaft etwas abkühlt, werden auch wieder mehr Kapazitäten frei für solche Prozesse. Man muss auch sehen: neue Sensoren, Software, Datenbanken, Datenconsulting etc., das kostet erstmal auch alles eine ganze Stange Geld und Zeit. Voran gehen daher natürlich vor allem die größeren Unternehmen, die das leichter finanzieren können und auch das entsprechende Personal bzw. die Ressourcen hierfür haben.

Also keine Goldgräber-Stimmung?

Wir sind ja auch nicht der wilde Westen (lacht)! Klar gibt es sehr vielversprechende Initiativen und einige, die das relativ unbestellte Feld im Materialbereich zu nutzen wissen, aber dieses „Digital first, Bedenken second“ ist auch einfach nicht der deutsche Weg und das aus gutem Grund. Auf Nummer sicher gehen, hat sich in diesem Land vielfach bewährt und das hat langfristig gesehen auch eine Nachhaltigkeitskomponente, die nicht zu vernachlässigen ist. Hier gibt es außerdem auch anders als in den USA auch nicht so viel leicht verfügbares Kapital, mit dem eine „fail fast-Mentalität“ querfinanziert werden könnte. Derzeitige Vorbehalte und Ängste sind völlig normal. Der Gesetzgeber kann aber seinen Teil dazu beitragen, die Bedenken möglichst klein zu halten und für weitere Klarheit sorgen.

Wo liegen denn die Unklarheiten? Was sind aktuell die größten Baustellen?

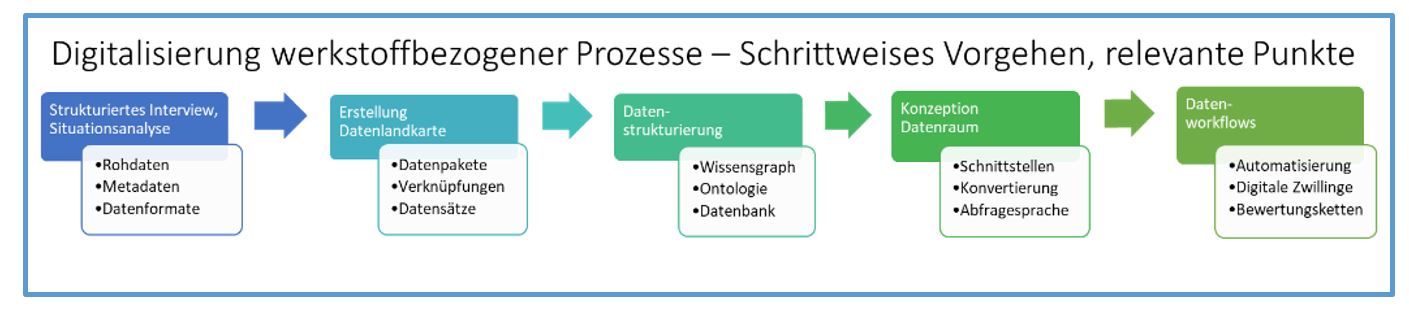

Ein wichtiges Thema ist die Trennung von Maschinendaten und personenbezogenen Daten. Sobald ein Personenbezug in deinen Daten drin ist, greift das Datenschutzrecht. Anders als vielfach dargestellt lässt auch das Datenschutzrecht zwar relativ viel zu, aber der große Unterschied ist, dass man zu diesem Zeitpunkt nicht mehr darum herum kommt, sich mit der Materie der DSGVO und des BDSG zu beschäftigen. Ich muss dann beispielsweise Informationspflichten nachkommen, ggf. Einwilligungen einholen etc. und das bindet Ressourcen. Das muss jedem klar sein. Selbst das Löschen von Daten ist im Grundsatz ein Datenverarbeitungsfall, der eine Rechtsgrundlage erforderlich macht. Unsere Empfehlung ist daher, Daten bereits vor der Erfassung so zu strukturieren, dass der Verarbeitungsaufwand niedrig bleibt, vor allem weil eben kein Personenbezug enthalten ist.

Falls es nicht ohne personenbezogene Daten geht, beispielsweise wenn Schichtpläne mit im Spiel sind, sollten Maschinenhersteller die Interfaces so anlegen, dass Zugriffsrechte auf die verschiedenen Daten im Sinne eines „Clean Teams“, sich in klar von einander abgegrenzte Bereiche aufteilen und ein Werkstoffwissenschaftler wirklich auch nur auf die Maschinendaten zugreifen kann, ohne die personenbezogenen Daten überhaupt zu Gesicht zu bekommen. Dann kann vielfach argumentiert werden, dass die reinen Maschinendaten eben doch keinen Personenbezug aufweisen, was die Verarbeitung der Daten deutlich erleichtern kann.

Gibt es nicht auch Interesse an den personenbezogene Daten?

Im Maschinenbau zumindest von Seiten der Hersteller sind die Begehrlichkeiten ziemlich niedrig - im Gegenteil.

„Die Devise lautet eher »bleib mir Weg mit diesen Daten«.“

Personenbezogenen Daten bedeuten oft rechtliche Herausforderungen, aber bringen kaum einen Nutzen. Daher wird vielfach in Verträge aufgenommen, dass der Betreiber unter keinen Umständen personenbezogenen Daten an den Verarbeiter der Daten zu übermitteln hat. Bei den Betreibern ist das naturgemäß schon ein bisschen anders, denn bei ihnen geht es ja unter Umständen auch um Performance der Mitarbeiter.

Ich glaube aber, es ist auch wichtig zu differenzieren zwischen Industrie- und Consumerprodukten. Beispielsweise hat die Automobilindustrie einen ganz anderen Kontakt mit personenbezogen Daten. Das Auto von heute erfasst ja eine Unmenge an Daten. Nicht nur das Fahrverhalten der unterschiedlichen Fahrer eines Automobils erlauben Rückschlüsse auf Personen, sondern auch zunächst unscheinbare Dinge wie unterschiedliche Spotify-Logins etc.

Wie sieht es denn mit der Datenverfügbarkeit aus? Ist genug „Rohstoff“ da?

Vor einigen Jahren hatten wir eine Diskussion zu Dateneigentumsrechten. Der ehemalige EU-Kommissar für Digitale Wirtschaft Günther Öttinger forderte ein „BGB für Daten“. Die Industrie will so etwas unter keinen Umständen, denn wer soll das sein, der Eigentümer? Ist es der Hersteller der Maschine, der, der die Daten erhebt, oder vielleicht eher der Hersteller des konkreten Sensors, der die Werte erfasst oder ist es doch eher der Betreibers oder vielleicht sogar der Arbeitnehmer, der die Taste gedrückt hat? Sie sehen, dass ist sehr praxisfern, jemandem ein Eigentum zuzuordnen, das mit umfassenden Rechten verbunden ist. Gehören mir die Daten, darf ich sie verschenken, verleihen, oder einfach auch die Tür zu machen und keinen mehr teilhaben lassen. Unterschiedliche Interessenlagen sollten daher lieber zwischen den Parteien vertragsrechtlich geregelt werden, wir sprechen dann also eher von „Datenhoheit“ als von Dateneigentum.

Die ganz große Mehrheit unserer Mitglieder hat keine Probleme, Zugangsrechte mit ihren Kunden zu vereinbaren. Das liegt vor allem am Servicedenken und dem guten Draht zum Kunden. Da fällt es oft beiden Seiten leicht, die Mehrwerte zu vermitteln. Hin und wieder kommt allerdings auch mal die Frage auf: „Weiß euer Kunde eigentlich, dass ihr seine Maschine rund um die Uhr überwacht?“ Das führt unabhängig vom rechtlichem Aspekt zu einer Vertrauensstörung, die nachhaltig schaden kann. Solange es keine vertragsrechtlichen Grundlage für einen geordneten Datenzugriff gibt, kann die Weigerung eines Maschinenbetreibers schnell ganze Geschäftsmodelle einreißen. Daher predige ich auch Transparenz von Anfang an, anstatt einfach loszurennen. Der Kunde muss wissen, was mit den Daten geschieht. Und er muss verstehen, was er davon hat, die Daten zu teilen.

Auf der anderen Seite haben Daten den intrinsischen Drang, sich selbstverstärkend zu agglomerieren. Hier könnte eine Monopolisierung von Daten drohen, das konnten wir die letzten Jahrzehnte bei personenbezogenen Daten beobachten. Wie attraktiv kann ein soziales Netzwerk mit ein paar Tausend Teilnehmern sein im Gegensatz zu Facebook mit mehreren Milliarden Nutzern? Gleiches gilt für Datenplattformen: Es muss möglich sein, hier einen ausreichenden Wettbewerb sicherzustellen, der die Abhängigkeiten minimiert.

Müssen wir also ein „Google der Materialdaten“ fürchten?

Noch haben wir keinen Kipppunkt, aber wenn am Ende des Tages dann alle Daten bei einem großen Anbieter landen, dann hilft uns das Vertragsrecht relativ wenig. Unternehmen könnten dann aufgrund der Marktmacht in unvorteilhafte Verträge gezwungen werden, also z.B. mehr Daten übermitteln, als sie wollen oder die Datenhoheit über die Daten sogar verlieren. Die Angst, dass Google da zu irgendeinem Zeitpunkt selber mitmischen wird, ist aus meiner Sicht auch nicht komplett unbegründet.

Um hier den Wettbewerb sichern zu stellen, vor allem für kleine Unternehmen, wird der Gesetzgeber gerade aktiv. Wir hinken da momentan noch etwas hinterher. Aber Daten als Faktor der Marktmacht sind bereits etabliert. Die Datenzugangsdebatte, also ob ein Anspruch auf den Zugang zu Daten existiert, tangiert auf jeden Fall das Kartellrecht und das ist aus gutem Grund sehr restriktiv, aber leider auch sehr unflexibel. Wir bauen daher auf die 10. GBG Novelle, was nicht umsonst auch mit Digitalisierungsgesetz umschrieben ist. Diese soll den Zugangsanspruch vereinfachen, insbesondere wenn die Daten auf einem anderem Markt als dem, in dem die Daten erhoben werden, eingesetzt werden sollen. Allerdings darf es nicht soweit kommen, dass jeder Zugang zu jedweden Daten hat: Ein solche Datensozialismus würde zum einen wiederum nur die großen Datenunternehmen stärken, die dann ungehemmt zugreifen könnten. Zum anderen würde das massiv in die von uns geforderte vertragliche Lösung der Thematik eingreifen, vom Geheimnisschutz, also dem Schutz von wertvollstem Know How der Branche, ganz zu schweigen. Es muss zunächst ein Marktversagen festgestellt werden, damit ein Zugangsanspruch zu Daten überhaupt in Frage kommt.

Ein Beispiel wären Auslastungsdaten einer Bearbeitungsmaschine in der Automobilindustrie, die auch für einen Energieversorger interessant wären, um Lastspitzen zu kalkulieren. Die Daten betreffen damit nicht direkt das Geschäft des Hauptkunden und könnten daher auf Grundlage der Gesetzesnovelle mit einem Zugangsanspruch versehen werden und damit leichter genutzt werden.

Was ist ihr Rat an Unternehmen, um in diesen dynamischen Zeiten zu bestehen? Brauchen Werkstoffexperten jetzt einen Rechtsbeistand?

Wie so oft liegt die Lösung in der verbesserten Kommunikation. Die Digitalisierung erzwingt das interdisziplinäre Denken und entlohnt Unternehmen, die das hinbekommen; die ein Zusammenspiel zwischen ihren Bereichen etablieren und dazu ihre Ausdrucksweisen runterfahren. Damit meine ich, dass Juristen mit der richtigen Sprache einen stärkeren Einblick in die technischen Möglichkeiten und Notwendigkeiten bekommen können und umgekehrt die Fachabteilungen in die rechtlichen Rahmenbedingungen und Fallstricke. Wenn wir möglichst frühzeitig die andere Seite mit einbinden, dann haben wir uns beim „deutschen Modell“ nicht nur technisch abgesichert, sondern auch rechtlich.

nach oben

Fraunhofer-Institut für Werkstoffmechanik IWM

Fraunhofer-Institut für Werkstoffmechanik IWM